Förderphase I

Sie ermöglichen den anderen Teilprojekten, die anfallenden Daten schneller zu analysieren, zu verstehen und Fragen, die beim Erarbeiten einer Methodik für adaptive Strukturen anfallen, besser zu beantworten.

Um dieses Ziel zu erreichen, werden im Teilprojekt folgende Fragen erforscht:

• Mit welchen spezialisierten Techniken lassen sich adaptive Strukturen unter Berücksichtigung der bestehenden Prozesse und bewährten Metaphern gegenständlich sowie abstrakt visualisieren?

• Welche Methoden zur Visualisierung der anfallenden Daten eignen sich dazu, die durchgeführten Simulationen zu analysieren und die entworfenen Strukturen zu bewerten?

• Wie können neben der durch äußere Faktoren beeinflussten Festigkeit der Strukturen auch die mechanischen, thermischen und akustischen Zustände in einem integrativen Ansatz visualisiert werden?

• Welche Repräsentation eignet sich zur kombinierten Analyse von Daten im Inneren und auf der Oberfläche von Strukturen?

• Wie lassen sich entwickelte Simulationsmethoden reduzieren?

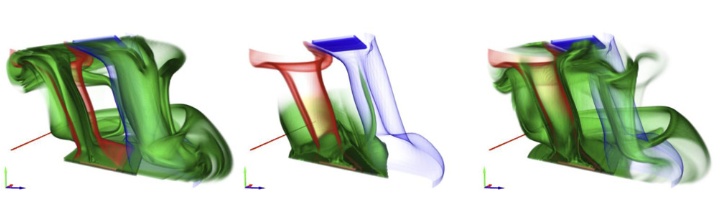

In einem integrierten Ansatz sollen die mechanischen, thermischen und akustischen Zustände adaptiver und ultraleichter Strukturen visualisiert werden. Um eine ganzheitliche, interaktive visuelle Analyse zu unterstützen, sollen die Visualisierungen eng gekoppelt werden. Dazu werden neue Techniken zur Visualisierung der anfallenden Daten entwickelt. Sie sollen helfen, die durchgeführten Simulationen zu analysieren und die entworfenen Strukturen zu bewerten.

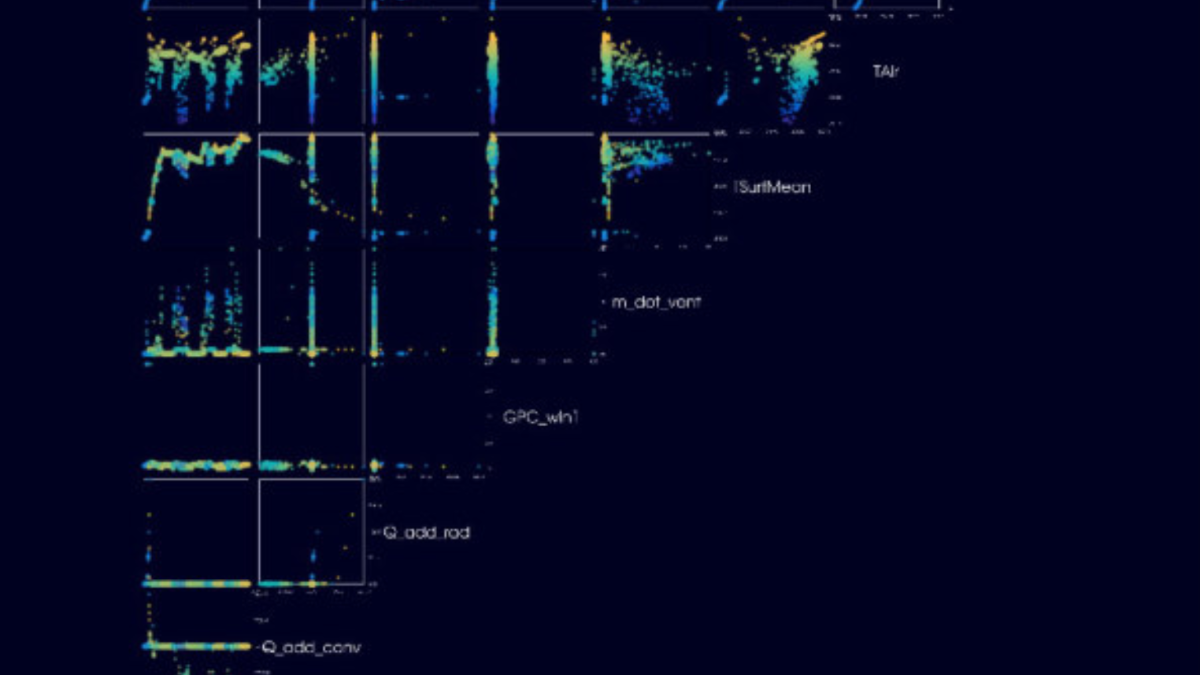

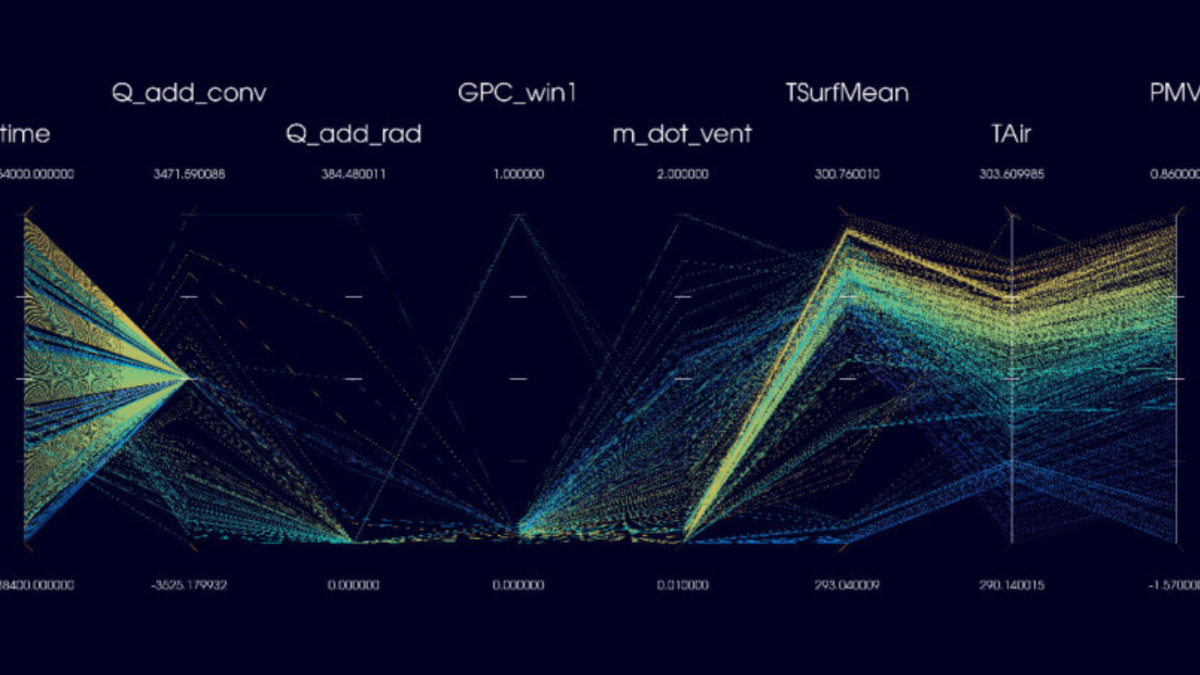

Die Ergebnisse der entsprechenden Simulationen werden zunächst einzeln und mit bekannten Ansätzen zur Darstellung von Geometrienetzen sowie Skalar- und Vektorfeldern visualisiert, wobei eine geeignete Repräsentation für die kombinierte Analyse von Daten im Innern und auf der Oberfläche der Strukturen gefunden werden muss. Darauf aufbauend sollen sowohl neue individuelle Ansätze als auch deren Kombination untersucht und umgesetzt werden, um die Menge an Varietäten und die hohe Dimension der Parameterräume beherrschbar zu machen. Um unterschiedliche Ausprägungen physischer Bestandteile eines Gebäudes sowie unterschiedliche Methoden der Simulation deren Verhaltens schnell und umfassend bewerten zu können, sollen vergleichende Visualisierungen konzipiert werden.

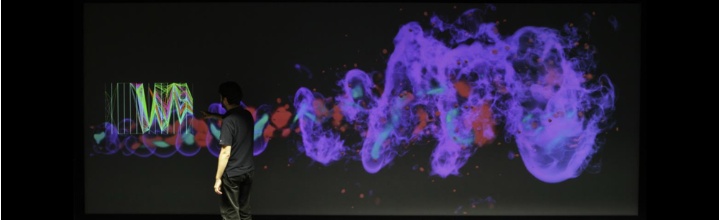

Volumenrendering eines Druckfeldes auf der VISUS Powerwall. Durch Anzeige der Visualisierungsparameter im Kontext kann z.B. die Visualisierung in Bezug auf Performance und Qualität gleichzeitig mit den strukturellen Eigenschaften des Datensatzes analysiert werden

Volumenrendering eines Druckfeldes auf der VISUS Powerwall. Durch Anzeige der Visualisierungsparameter im Kontext kann z.B. die Visualisierung in Bezug auf Performance und Qualität gleichzeitig mit den strukturellen Eigenschaften des Datensatzes analysiert werden

Foto: VISUS

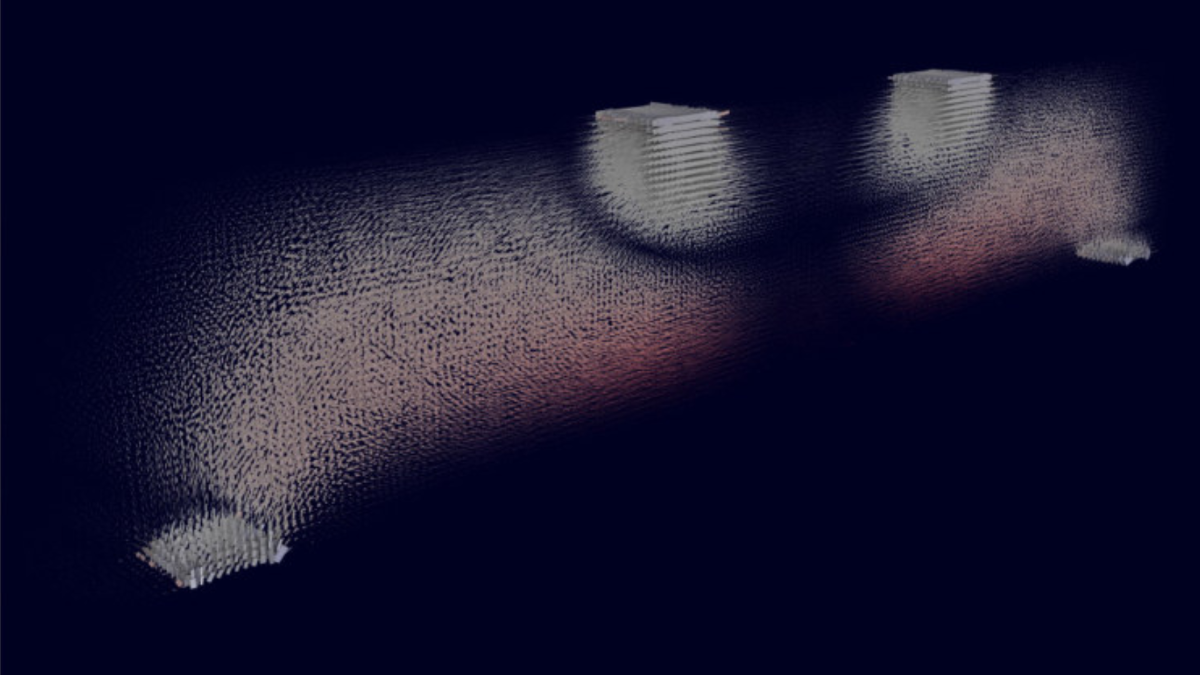

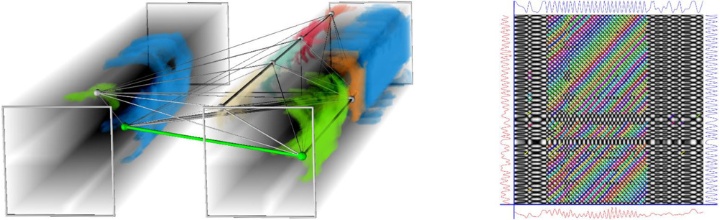

Links: Temperaturentwicklung in zwei 2D-Räumen. Die Zeit verläuft von vorne nach hinten, die Knoten sind Repräsentanten für den jeweiligen Cluster, die Dicke der Verbindungslinie bildet ein Korrelationsmaß ab. Rechts: Zeitliche Ähnlichkeitsmatrix zur direkten Darstellung

Links: Temperaturentwicklung in zwei 2D-Räumen. Die Zeit verläuft von vorne nach hinten, die Knoten sind Repräsentanten für den jeweiligen Cluster, die Dicke der Verbindungslinie bildet ein Korrelationsmaß ab. Rechts: Zeitliche Ähnlichkeitsmatrix zur direkten Darstellung

Foto: VISUS

Visualisierung des Wärmeauftriebs mithilfe von simulierter, grüner Tinte, welche an der heißen, roten Platte einfließt

Foto: VISUS

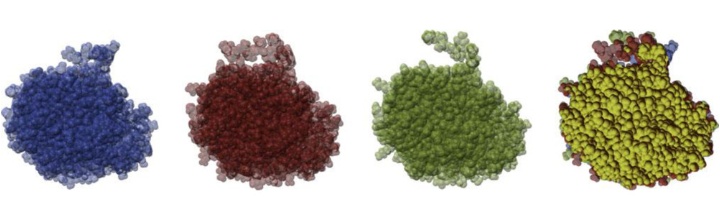

Die Van-der-Waals Oberfläche des Lipase-2-Proteins in drei verschiedenen Varianten. Mit Hilfe von „Per-Pixel Linked Lists“ können gemeinsame Bereiche direkt beim Rendering gefunden und opak dargestellt werden (in gelb, ganz rechts). Bereiche, die nicht in allen Varianten vorkommen, sind so deutlich sichtbar

Die Van-der-Waals Oberfläche des Lipase-2-Proteins in drei verschiedenen Varianten. Mit Hilfe von „Per-Pixel Linked Lists“ können gemeinsame Bereiche direkt beim Rendering gefunden und opak dargestellt werden (in gelb, ganz rechts). Bereiche, die nicht in allen Varianten vorkommen, sind so deutlich sichtbar

Foto: VISUS

Eine Auswahl von 10x4 Konformationen eines Proteins in Oberflächendarstellung zum Vergleich auf der VISUS Powerwall

Foto: VISUS

Die entwickelten Methoden basieren auf dem neusten Stand der Wissenschaft und Technik. Damit sie auch auf weniger leistungsfähigen Computern sinnvoll eingesetzt werden können, wird zusätzlich eine Reduktion der visuellen Analysemethoden untersucht.

Das Teilprojekt B05 liefert den anderen Teilprojekten interaktive, visuelle Analysemethoden, um deren Modelle und Ergebnisse darzustellen, zu verstehen und zu validieren.

Teilprojektleiter:innen

- Prof. Dr. rer. nat. Dr. techn. h.c. Dr.-Ing. E.h. Thomas Ertl, Institut für Visualisierung und Interaktive Systeme

- Dr. rer. nat. Guido Reina, Visualisierungsinstitut der Universität Stuttgart

Förderphase II

Die Datenanalyse im SFB 1244 beinhaltet zwei grundsätzliche Herausforderungen: Zum einen sind adaptive Strukturen und Hüllen Gegenstand der Forschung und in vielerlei Hinsicht topologisch und geometrisch parametrierbar.

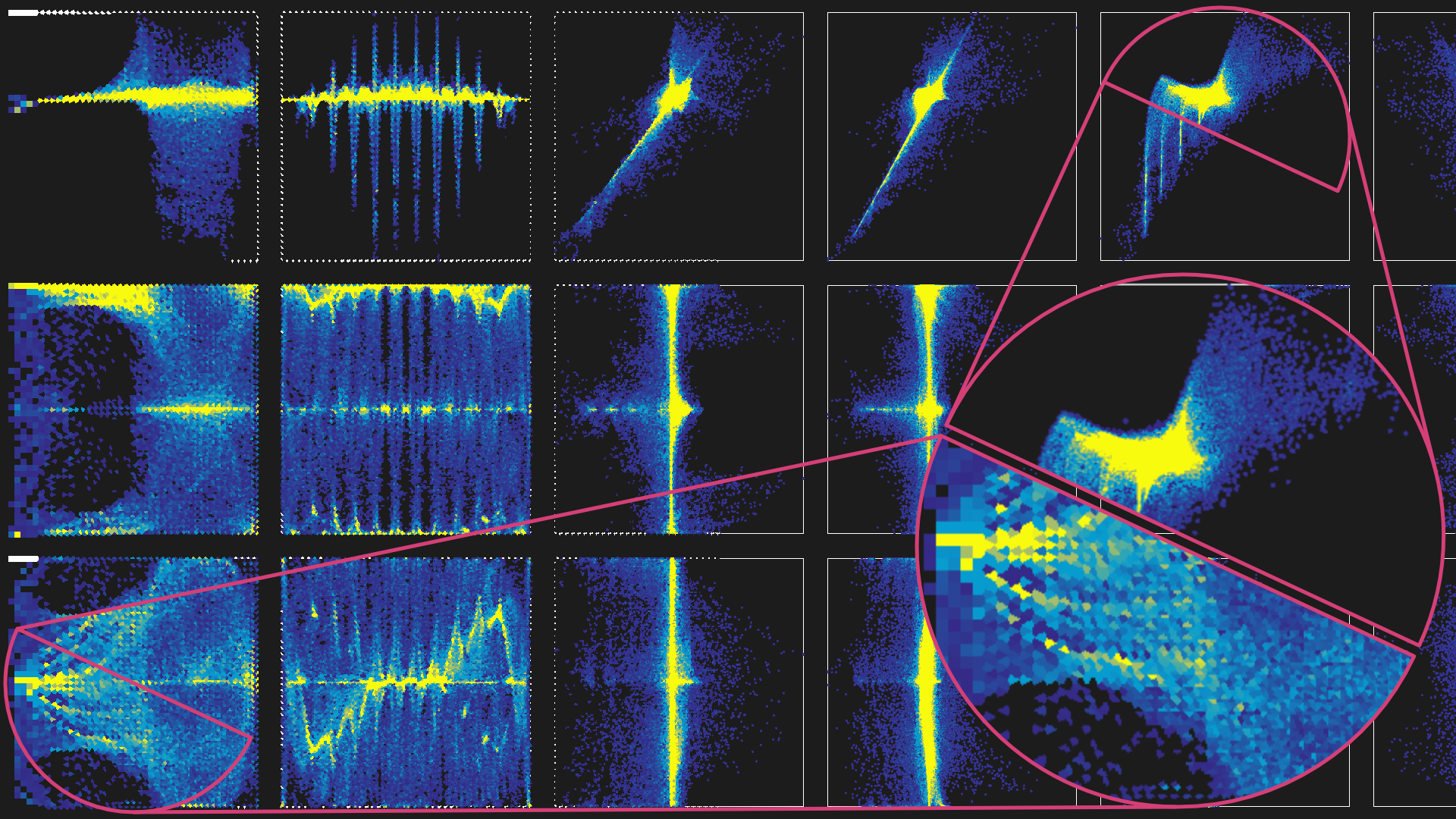

Unsere Methode zur Beschleunigung von 2D-Visualisierungen durch dynamische Auflösungsskalierung und zeitliche Rekonstruktion. Neu in das Bild eintretende Regionen werden nur mit geringer Auflösung gerendert, da keine früheren Bildinformationen verfügbar sind, während Regionen, die in früheren Bildern sichtbar waren, die volle Bildqualität beibehalten können. Foto: VISUS

Unsere Methode zur Beschleunigung von 2D-Visualisierungen durch dynamische Auflösungsskalierung und zeitliche Rekonstruktion. Neu in das Bild eintretende Regionen werden nur mit geringer Auflösung gerendert, da keine früheren Bildinformationen verfügbar sind, während Regionen, die in früheren Bildern sichtbar waren, die volle Bildqualität beibehalten können. Foto: VISUS

Es ist somit notwendig, den Forschenden der anderen Teilprojekte das Verständnis dieser hochdimensionalen und komplexen Daten zu erleichtern, sowohl auf abstrakter Ebene als auch im Kontext des Gegenständlichen.Dabei werden neue Visualisierungstechniken benötigt, die einen Vergleich unterschiedlicher Varianten und ein Verständnis der Unterschiede ermöglichen.

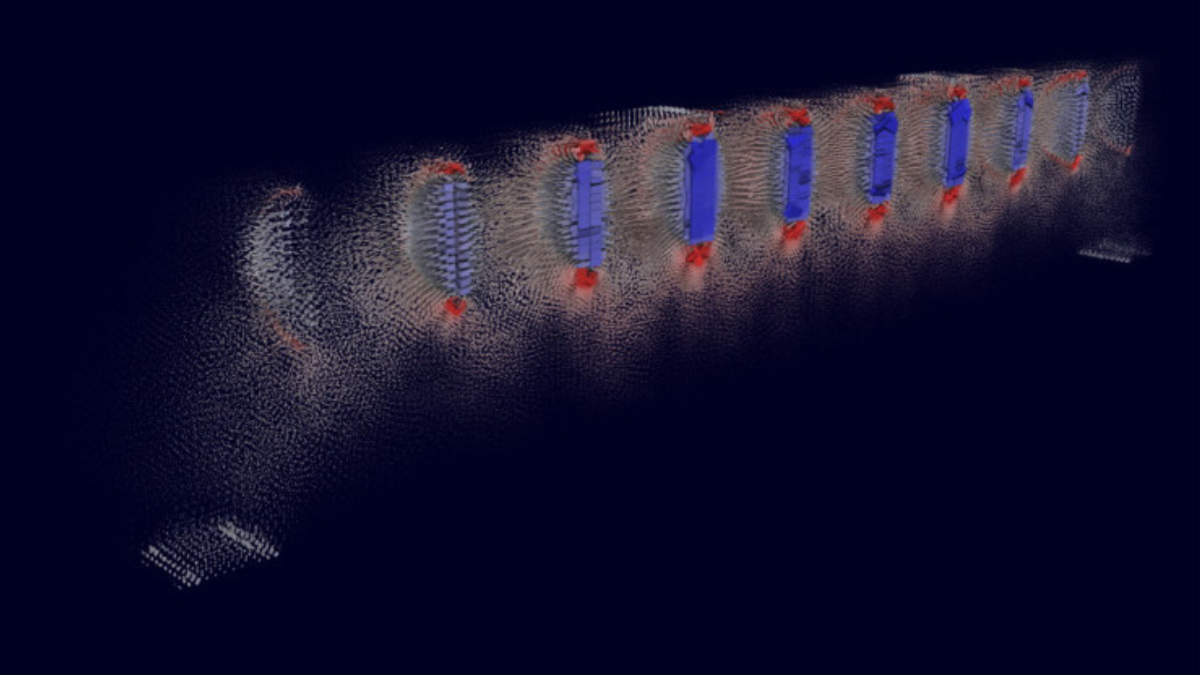

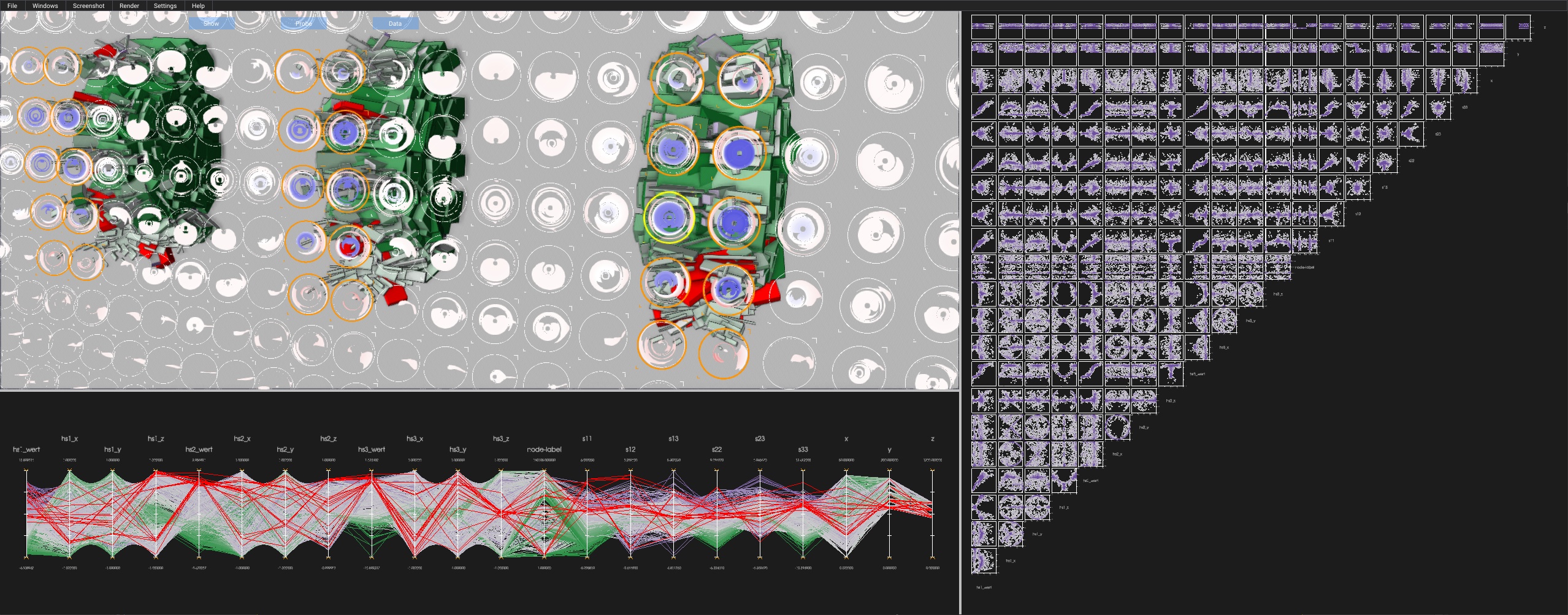

Visualisierung in einer verknüpften Ansicht, die unsere Probe-Glyphen mit 3D-Box-Glyphen, einem parallelen Koordinatendiagramm und einer Streudiagramm-Matrix kombiniert. Mit einer Auswahl auf den Probe-Glyphen wird der Datensatz gefiltert, um in der 3D-Ansicht Regionen von Interesse zu erkennen, die zuvor anhand der Glyphen identifiziert wurden. Die Filterung und Auswahl sind auch mit den 2D-Ansichten verknüpft. Foto: VISUS

Visualisierung in einer verknüpften Ansicht, die unsere Probe-Glyphen mit 3D-Box-Glyphen, einem parallelen Koordinatendiagramm und einer Streudiagramm-Matrix kombiniert. Mit einer Auswahl auf den Probe-Glyphen wird der Datensatz gefiltert, um in der 3D-Ansicht Regionen von Interesse zu erkennen, die zuvor anhand der Glyphen identifiziert wurden. Die Filterung und Auswahl sind auch mit den 2D-Ansichten verknüpft. Foto: VISUS

Zum anderen müssen die Visualisierungsansätze im Kontext des Demonstrator-Hochhauses effektiv arbeiten. Die Praxis zeigt hier, dass sowohl die Planungsgrundlagen als auch die Sensordaten und ihre Auswirkung auf die eingesetzte Regelungstechnik den Forschenden vor Ort zur Verfügung gestellt werden müssen, um einen effizienteren Arbeitsablauf zu gewährleisten.

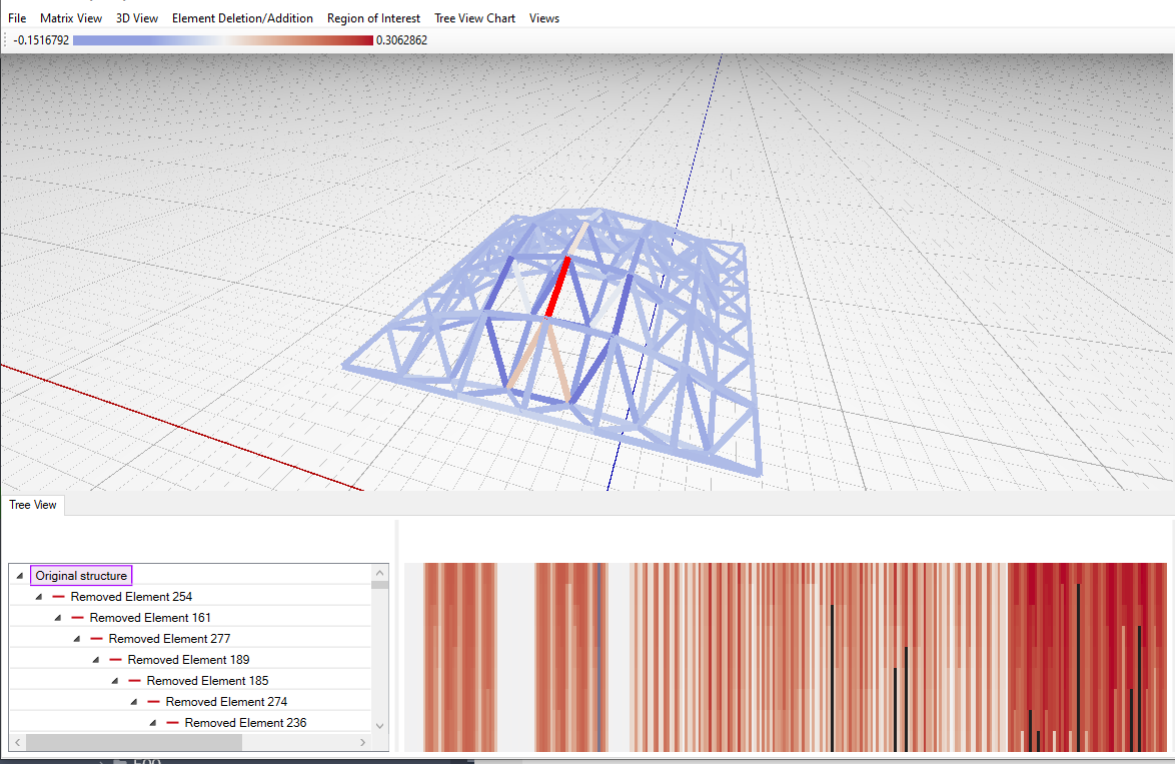

Visuelle Analyseanwendung für Redundanzmatrizen von Fachwerkstrukturen. ie ermöglicht die Erkundung eines Baums innerhalb des Entwurfsraums einer Struktur, der durch das Löschen und Hinzufügen von Elementen aufgefüllt wird. Zu den Ansichten gehören eine 3D-Ansicht und eine Matrixdarstellung (oben) sowie eine hierarchische Liste der Baumknoten mit verschiedenen Redundanzmatrixverteilungsdarstellungen (unten). Foto: VISUS

Visuelle Analyseanwendung für Redundanzmatrizen von Fachwerkstrukturen. ie ermöglicht die Erkundung eines Baums innerhalb des Entwurfsraums einer Struktur, der durch das Löschen und Hinzufügen von Elementen aufgefüllt wird. Zu den Ansichten gehören eine 3D-Ansicht und eine Matrixdarstellung (oben) sowie eine hierarchische Liste der Baumknoten mit verschiedenen Redundanzmatrixverteilungsdarstellungen (unten). Foto: VISUS

Eine zentrale Rolle spielt hierbei Augmented Reality (AR), wodurch relevante Daten unmittelbar im Kontext der realen Umgebung des Demonstrators visualisiert und analysiert werden können.Die visuelle Aufbereitung und Darstellung von Sensordaten müssen dabei in Echtzeit erfolgen.

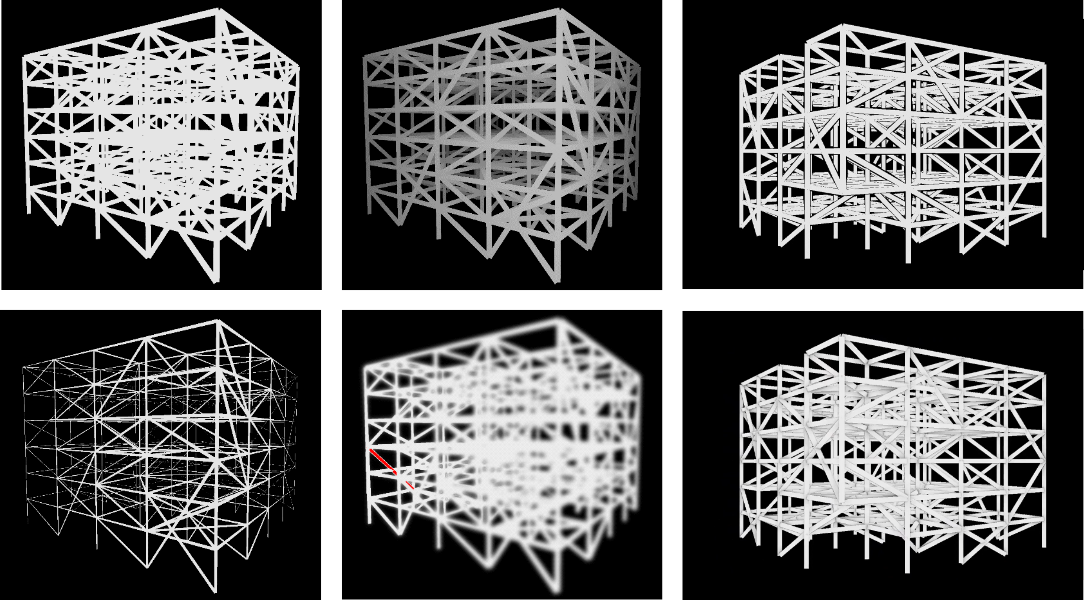

Mehrere Optionen zur Verbesserung der Tiefenwahrnehmung einer Fachwerkstruktur (von links nach rechts, von oben nach unten: Standard-Darstellung, Helligkeitsabschwächung, Tiefen-Halos, Liniendicke, Defokussierung, Ambient Occlusion). Foto: VISUS

Mehrere Optionen zur Verbesserung der Tiefenwahrnehmung einer Fachwerkstruktur (von links nach rechts, von oben nach unten: Standard-Darstellung, Helligkeitsabschwächung, Tiefen-Halos, Liniendicke, Defokussierung, Ambient Occlusion). Foto: VISUS

Das Teilprojekt wird teilweise die Forschung aus der ersten Förderperiode weiterführen, um eine Kontinuität in der Entwicklung der benötigten Visualisierungsverfahren zu gewährleisten.

Durch die im Vergleich zur ersten Förderperiode komplexeren Simulationen und die flächendeckend installierte Sensorik werden deutlich größere Datenmengen anfallen.

Die Erweiterung der Forschung auf Gebäudehüllen wirkt sich nicht nur auf wachsende Datenmengen, sondern auch auf eine komplexere Struktur der zu visualisierenden Bauwerke aus, insbesondere durch stärkere Verdeckungsprobleme und noch komplexere Interaktionen der untersuchten Komponenten untereinander.Trotz dieser Skalierungsproblematik muss die Visualisierung ein intuitives Verständnis der Eigenschaften eines adaptiven Gebäudes und dessen spezifischer Ausprägung ermöglichen. Mangels einer etablierten Entwurfs- und Planungsmethodik für adaptive Gebäude muss darüber hinaus die Möglichkeit geschaffen werden, unterschiedliche Ausprägungen zu vergleichen.

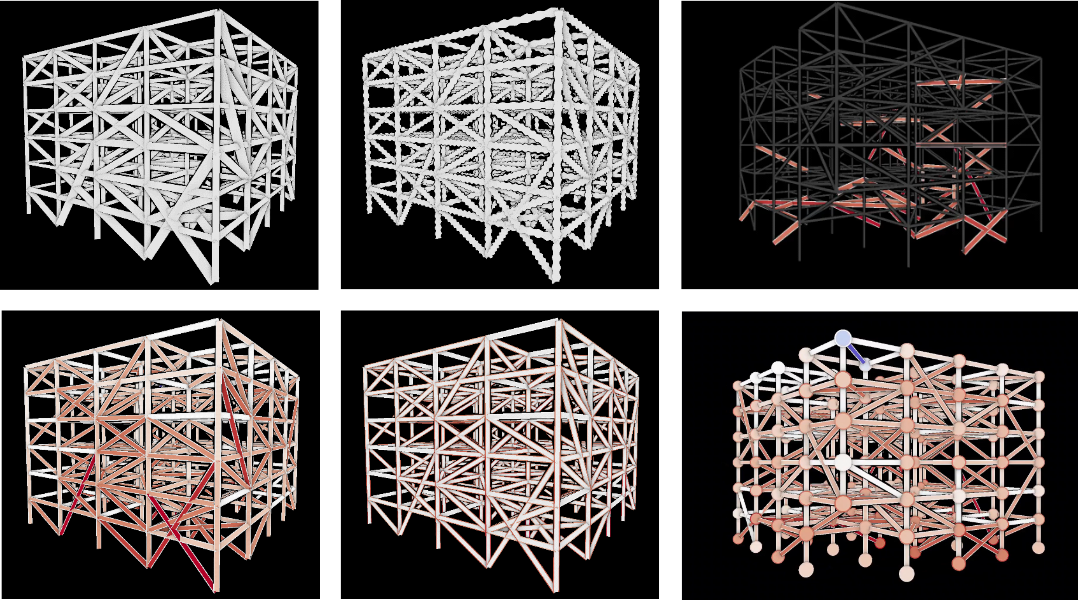

Verschiedene Optionen für Multi-Attribut-Visualisierungen auf den Elementen oder Knoten einer Fachwerkstruktur (von links nach rechts, von oben nach unten: Liniendicke, Linienform, gefilterte Linien, Linienfüllfarbe, Linienstrichfarbe, Knotengröße und Farbe). Foto: VISUS

Verschiedene Optionen für Multi-Attribut-Visualisierungen auf den Elementen oder Knoten einer Fachwerkstruktur (von links nach rechts, von oben nach unten: Liniendicke, Linienform, gefilterte Linien, Linienfüllfarbe, Linienstrichfarbe, Knotengröße und Farbe). Foto: VISUS

Ein Forschungsziel ist die Entwicklung von Interaktions- und Visualisierungstechniken zur Vor-Ort-Analyse. Hierfür sind Fortschritte bezüglich der Interaktionsarten, der räumlichen Lokalisierung und skalierbarer Algorithmen für die eher leistungsschwache mobile AR-Hardware notwendig.

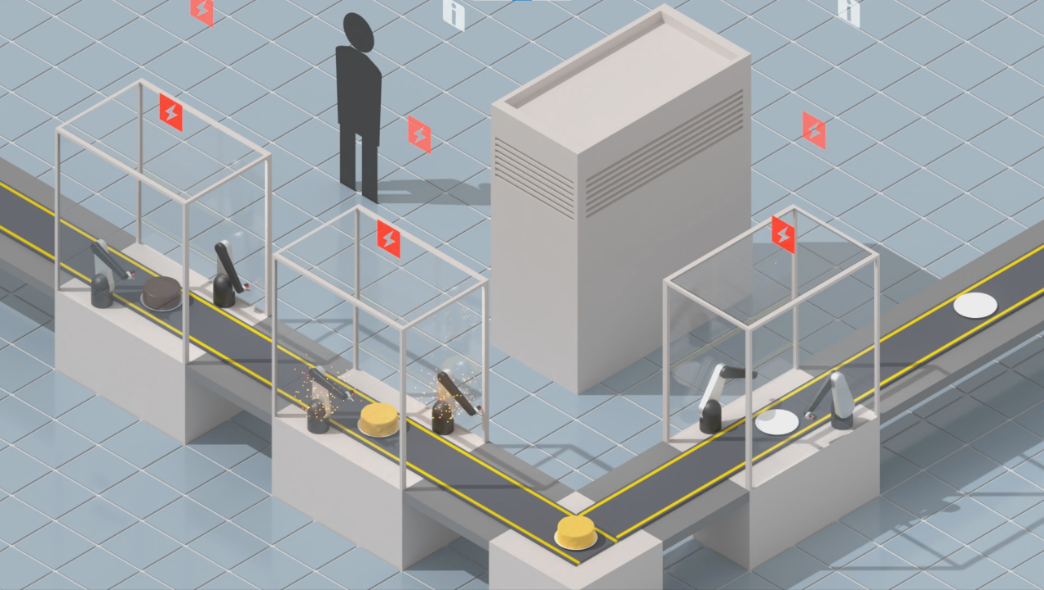

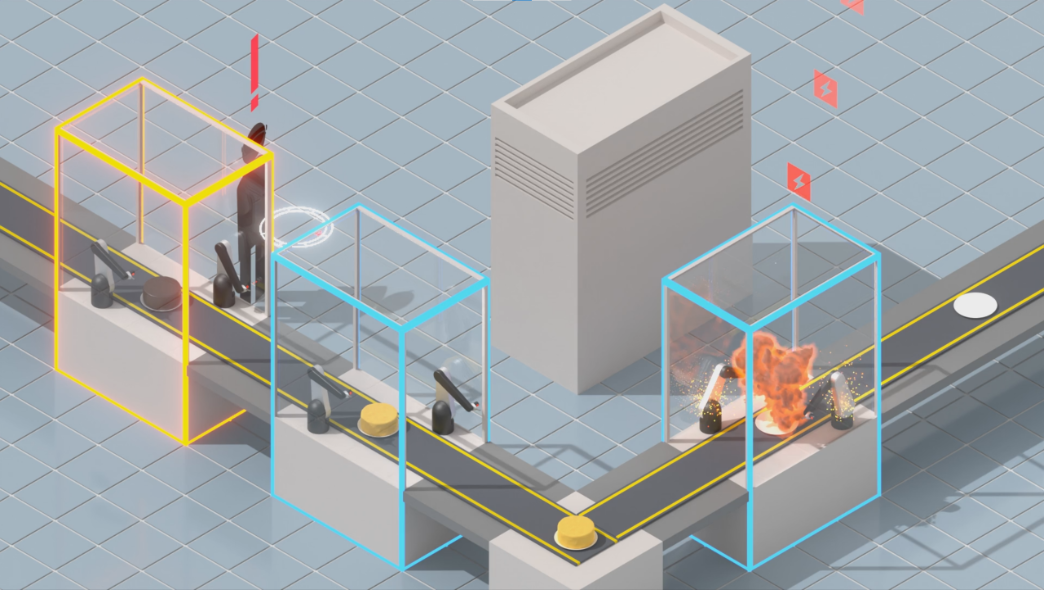

Moderne, mit Sensoren ausgestattete Maschinen, hier im Rahmen einer automatisierten Produktionslinie, produzieren kontinuierlich Daten in Echtzeit über ihren Fortschritt und wichtige Ereignisse, z. B. Störungen. Foto: VISUS

Moderne, mit Sensoren ausgestattete Maschinen, hier im Rahmen einer automatisierten Produktionslinie, produzieren kontinuierlich Daten in Echtzeit über ihren Fortschritt und wichtige Ereignisse, z. B. Störungen. Foto: VISUS

Zudem lassen sich bekannte Visualisierungstechniken nicht direkt in AR-Anwendungen übertragen. Entsprechende Anpassungen für eine situierte Visualisierung müssen unter anderem den Kontext der realen Umgebung, aber auch das Zusammenspiel zwischen virtuellen Dateninhalten und der Umwelt berücksichtigen.

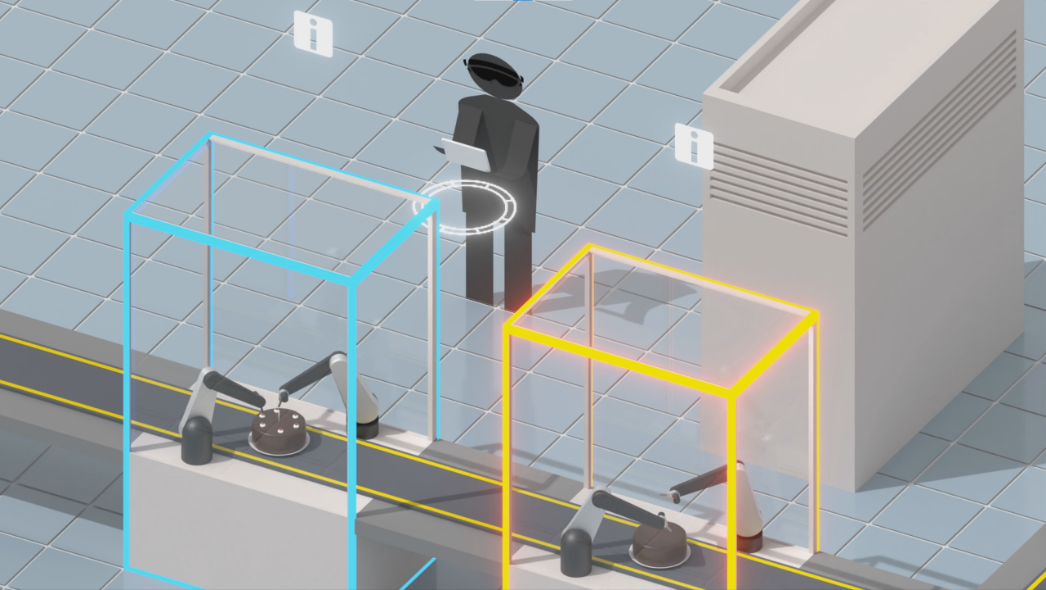

Die Aufgabe der Bedienenden vor Ort hat sich auf die Überwachung von Maschinen und die schnellstmögliche Erkennung und Behebung von Störungen verlagert. Um diese Aufgaben zu unterstützen, bietet unser Ansatz eine Echtzeit-Überwachung und visuelle Analyse vor Ort mithilfe eines Tablet-Computers und eines AR-HMD: Die AR-Ansicht hebt einzelne Maschinen hervor und liefert zeitnahe Benachrichtigungen und räumliche Hinweise auf Störungsereignisse in einem virtuellen Kompass. Foto: VISUS

Die Aufgabe der Bedienenden vor Ort hat sich auf die Überwachung von Maschinen und die schnellstmögliche Erkennung und Behebung von Störungen verlagert. Um diese Aufgaben zu unterstützen, bietet unser Ansatz eine Echtzeit-Überwachung und visuelle Analyse vor Ort mithilfe eines Tablet-Computers und eines AR-HMD: Die AR-Ansicht hebt einzelne Maschinen hervor und liefert zeitnahe Benachrichtigungen und räumliche Hinweise auf Störungsereignisse in einem virtuellen Kompass. Foto: VISUS

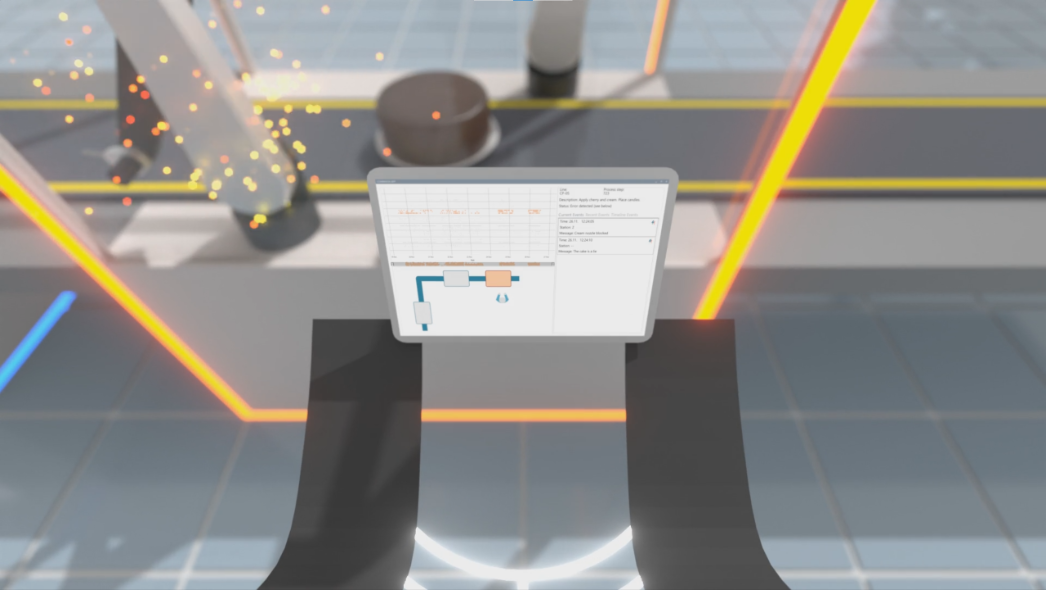

Der Tablet-Computer liefert Details über Fehlfunktionen und historische Daten, um die Benutzenden während des Reparaturprozesses zu informieren. Foto: VISUS

Der Tablet-Computer liefert Details über Fehlfunktionen und historische Daten, um die Benutzenden während des Reparaturprozesses zu informieren. Foto: VISUS

Über die AR-Ansicht können neue Störungsereignisse, die außerhalb des Sichtfelds des Bedieners auftreten, sofort bemerkt werden. Foto: VISUS

Über die AR-Ansicht können neue Störungsereignisse, die außerhalb des Sichtfelds des Bedieners auftreten, sofort bemerkt werden. Foto: VISUS

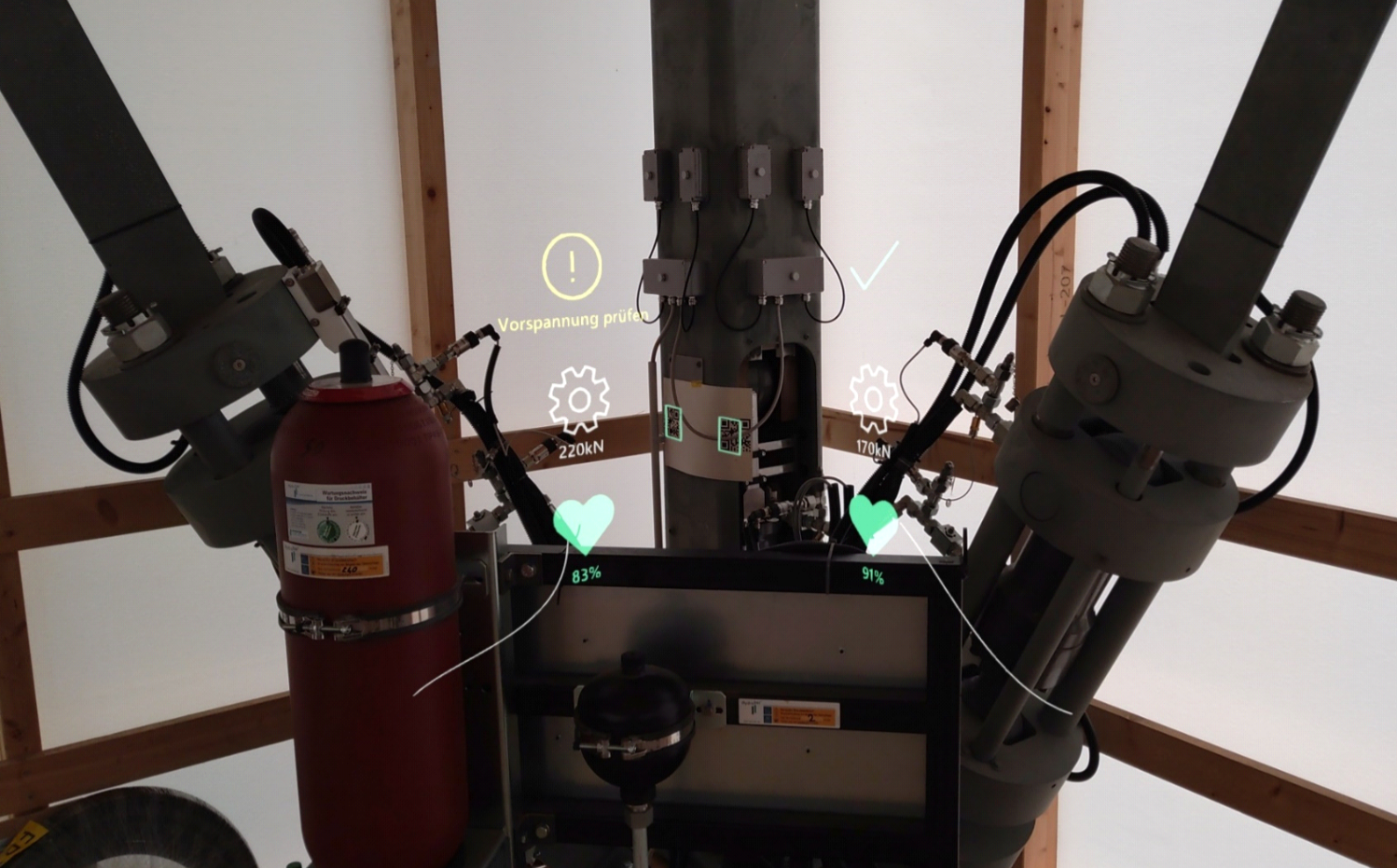

AR-Ansicht, die mit dem HMD aufgenommen wurde. Minimalistische, ortsgebundene Visualisierungen werden in der realen Welt platziert und visuell mit Bezugspunkten in der realen Welt verknüpft. Foto: VISUS

AR-Ansicht, die mit dem HMD aufgenommen wurde. Minimalistische, ortsgebundene Visualisierungen werden in der realen Welt platziert und visuell mit Bezugspunkten in der realen Welt verknüpft. Foto: VISUS

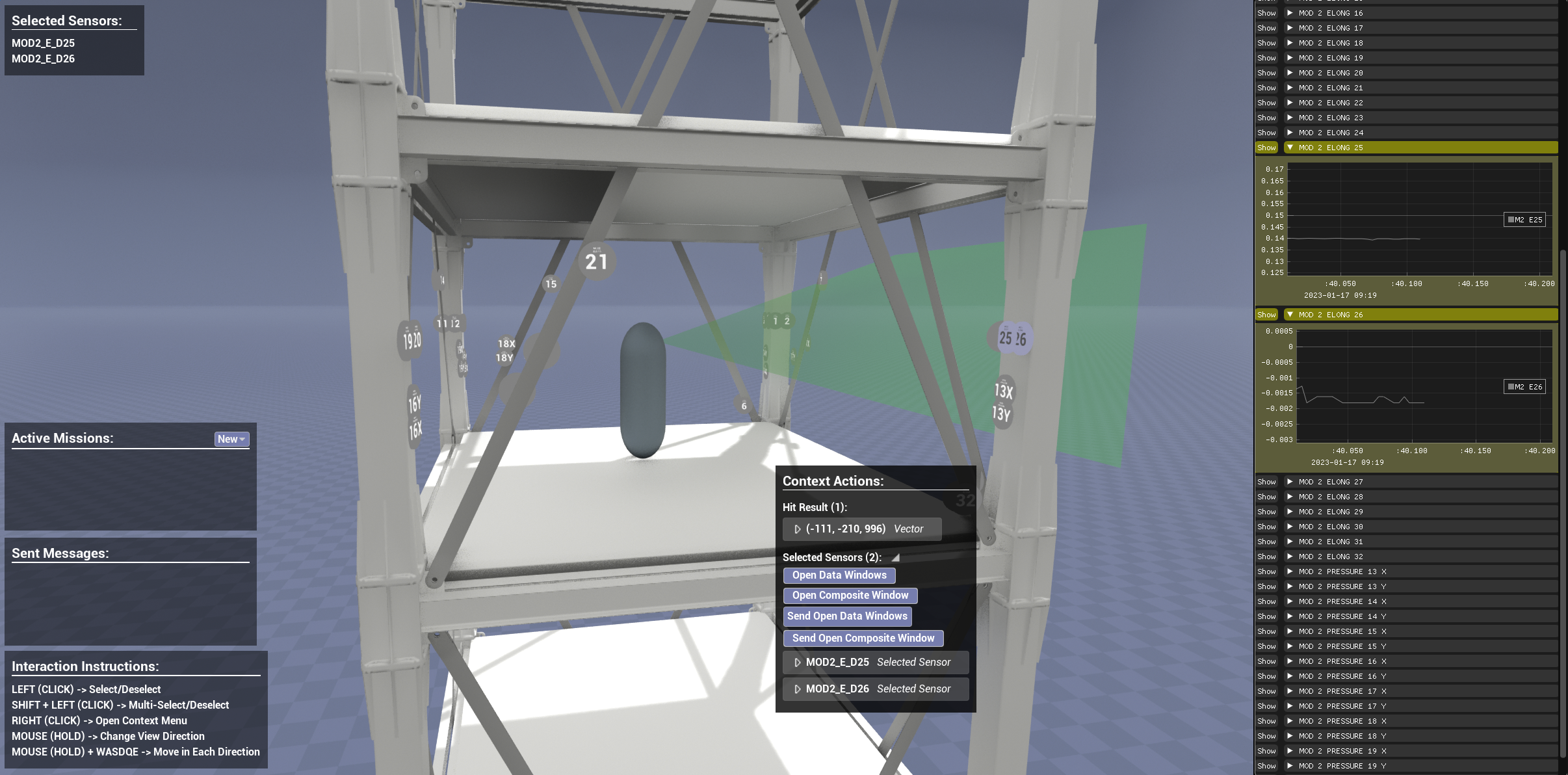

Eine desktopbasierte Anwendung bietet einen Überblick über die Live-Sensordaten des D1244. Diagramme werden in einer Liste oder eingebettet in die 3D-Ansicht an den Positionen der Sensoren im Gebäude angezeigt. Die Aktivitäten der HoloLens-Nutzer vor Ort werden geteilt, und Anweisungen können über einen asymmetrischen Kollaborationsansatz ausgetauscht werden. Foto: VISUS

Eine desktopbasierte Anwendung bietet einen Überblick über die Live-Sensordaten des D1244. Diagramme werden in einer Liste oder eingebettet in die 3D-Ansicht an den Positionen der Sensoren im Gebäude angezeigt. Die Aktivitäten der HoloLens-Nutzer vor Ort werden geteilt, und Anweisungen können über einen asymmetrischen Kollaborationsansatz ausgetauscht werden. Foto: VISUS

Ansprechpersonen

Michael Becher

M.Sc.Doktorand